Mobil und per Flatrate kommt man heute an praktisch jedem Ort der Welt mit einem Fingerwisch ins Internet – auf schicken Geräten, die kinderleicht zu bedienen sind. Das kann schnell vergessen lassen, dass dazu eine Infrastruktur nötig ist, die alles andere als virtuell ist – sondern eben echte Hardware: Millionen von Handymasten, Verteilerkästen, Knotenpunkten und Glasfaserleitungen, die sich quer durch Städte und Länder, Kontinente und Ozeane ziehen.

Fotos: Frank Goebel

Immer wichtiger für dieses globale Informationsnetz sind die Datenzentren: Komplexe, in denen Hunderte oder Tausende Server Tag und Nacht in Betrieb sind – also spezielle Computer, die nicht nur Daten horten, sondern auf Zuruf individuell aufbereitet in die Welt versenden.

Immer wichtiger für dieses globale Informationsnetz sind die Datenzentren: Komplexe, in denen Hunderte oder Tausende Server Tag und Nacht in Betrieb sind – also spezielle Computer, die nicht nur Daten horten, sondern auf Zuruf individuell aufbereitet in die Welt versenden.

Derzeit sind 23 solcher Rechenzentren über Luxemburg verteilt. Die Möglichkeit, dass Google sich in Bissen niederlassen könnte, bewegt gerade die Gemüter – nicht nur im betreffenden Gemeinderat.

Das derzeit größte Datenzentrum im Land dürften wohl die wenigsten Luxemburger kennen, obwohl viele jeden Tag daran vorbeikommen – beziehungsweise darüber fahren: Der „European Data Hub“ (EDH) liegt nämlich fünf Stockwerke tief unter der A6, zwischen den Autobahnkreuzen von Gasperich und Zessingen.

Vom spektakulär gestalteten Bürokomplex Drosbach-Center (Foto) führen große Aufzüge in die Tiefe, wo auf mehr als 5000 Quadratmetern Platz ist – nicht nur für Server. Denn ein Datenzentrum beherbergt noch viel mehr: „Prinzipiell stellen wir unseren Kunden vier Dinge zur Verfügung: Strom, Kühlung, Sicherheit und Konnektivität“, sagt Edward Hofmann, der im EDH für die Bereitstellung der Dienstleistungen und die Sicherheit zuständig ist.

Anders als die Datencenter etwa von Amazon oder Google, die vor allem eigene Daten verwalten, ist das EDH ein „Colocation“-Zentrum: Es vermietet die Infrastruktur an Kunden aus aller Welt. Die kommen aus praktisch allen denkbaren Bereichen, erklärt Hofmann: Handel, Banken und Finanzen, aber auch öffentliche Verwaltungen verschiedener Staaten, das Gesundheitswesen oder die Unterhaltungsbranche haben sich vor Ort eingemietet. Konkrete Namen lässt sich Hofmann nicht entlocken.

Schiffe versenken in der Hightech-Variante

Allerdings hat bereits 2011 ein Mitbegründer des EDH bekannt gegeben, dass ArcelorMittal praktisch seine gesamten IT-Aktivitäten in Europa in das Datenzentrum unter der A6 ausgelagert hat.

30 Jahre WWW: Das Netz und Luxemburg

Alle Artikel unserer WWW-Serie finden Sie hier.

Auch das weißrussische Software-Unternehmen Wargaming lässt durchblicken, dass er das EDH nutzt, um weltweit Hunderttausende Spieler zu vernetzen: Wenn diese sich in der Seeschlacht-Simulation „World of Warships“ mit Wasserbomben und Torpedos bekämpfen, rechnen die Computer im Luxemburger Datenzentrum aus, wer wo in der offenen Spielwelt unterwegs ist – und wer versenkt wird.

In einem YouTube-Clip verraten die Warships-Macher, dass ein Platz im Datenzentrum nicht nur wegen der guten Anbindung an die benachbarten Netzknoten wichtig ist: Denn der Komplex schützt die Spielwelt in den Servern auch vor ganz handfesten Bedrohungen wie Überhitzung oder Bränden. Auch Sabotageakten soll die vielfach redundant ausgelegte Infrastruktur abwehren können – zusammen mit meterdicken Mauern und einer rigorosen Zugangskontrolle. Außerdem wird für einen Stromausfall vorgesorgt: Im Computerzeitalter, in dem in einem Wimpernschlag Millionen von Rechenoperationen durchgeführt werden, kann jede Minute, in der ein Akteur nicht im Netz ist, eine geschäftliche Katastrophe bedeuten.

In der Tiefe lagern die Daten

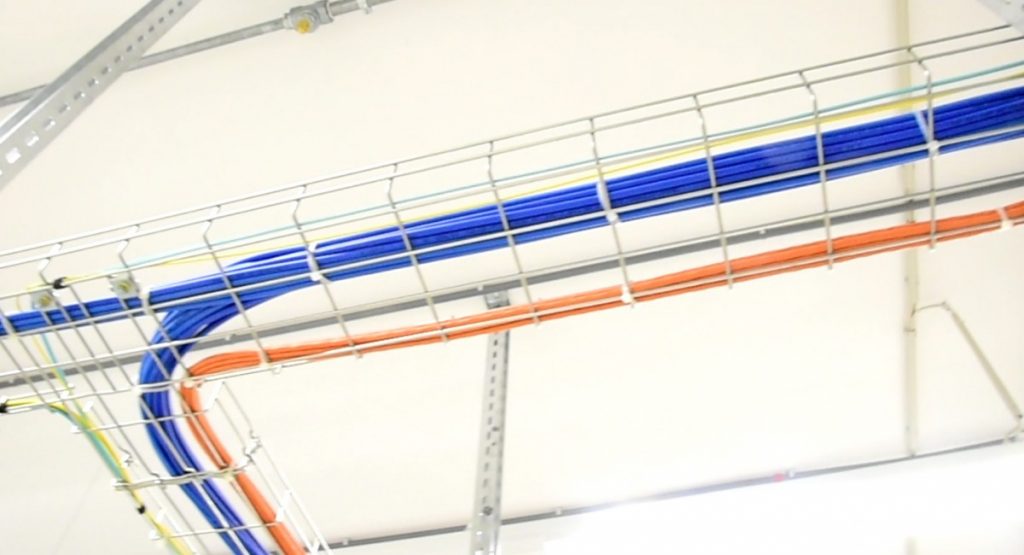

In der Tiefe unter dem Drosbach-Center, 12 bis 25 Meter unter der der Oberfläche, öffnet ein großer Lastenaufzug seine Türen: Der Blick wird frei auf den ersten von unzähligen funktional-weißen und endlos wirkenden Korridoren – die stets durchzogen sind von dicken Belüftungsrohren und bunten Kabelsträngen an den Decken. In mehr als 200 Räumen auf drei Stockwerken gehen hier ganze Maschinenparks unermüdlich ihren Aufgaben nach.

Im ersten Raum unseres Rundgangs sind das etwa in Reihe geschaltete Industrie-Akkus – die zu Dutzenden in großen Metallregalen gestapelt sind.

„Sie werden ständig durchgeladen, genau wie ein Handy, das dauernd am Stromnetz hängt“, sagt Hofmanns Kollege Julien Roncalli, der im Datenzentrum für die Energie zuständig ist. „Damit sind sie ein Teil unserer unterbrechungsfreien Stromversorgung.“

Angezapft werden sollen die Batterien nämlich erst, falls die externe Stromversorgung schwächelt – oder gar ausfällt: Selbst dann müssten die Säure-Akkus das Weiterlaufen der Server aber nur für ein paar Sekunden garantieren – nämlich bis die Notstrom-Aggregate des Centers angelaufen sind.

Auf dem Weg zu einem solchen Stromerzeuger geht es wieder durch etliche weiße Flure, eines von 120 Kameraaugen hat den Besucher dabei stets im Blick. Viele der 310 Türen im Komplex müssen per Code entsichert werden.

Plötzlich strömt kurz wieder Tageslicht von oben ein: Es geht durch einen Innenhof, der durch seine gut 20 Meter hohen Mauern eigentlich ein tiefer Schacht ist. Noch ein paar Türen – und dann steht man wieder in dem Raum mit den Batterien. Oder doch nicht?

Alles ist zweifach vorhanden

„Nein, wir sind nicht im Kreis gegangen“, erklärt Hofmann. Denn hier unten gibt es jeden Raum mitsamt seiner Ausstattung zweimal: Die gesamte Anlage ist an einer Spiegelachse komplett symmetrisch aufgebaut. „Durch diese Redundanz können wir die größtmögliche Ausfallsicherheit garantieren.“

Für diesen doppelten Aufwand darf sich das Datenzentrum unter anderem mit dem Zertifikat Tier IV schmücken: Diese durch das amerikanische Uptime Institute definierte Norm besagt, dass die Server 99,995 Prozent der Zeit laufen können – und somit nur maximal 26 Minuten pro Jahr offline sind. Diese höchstmögliche Zuverlässigkeit ist besonders wichtig für Firmen, deren Geschäftsbereich allerhöchste Standards verlangt – wie etwa Banken.

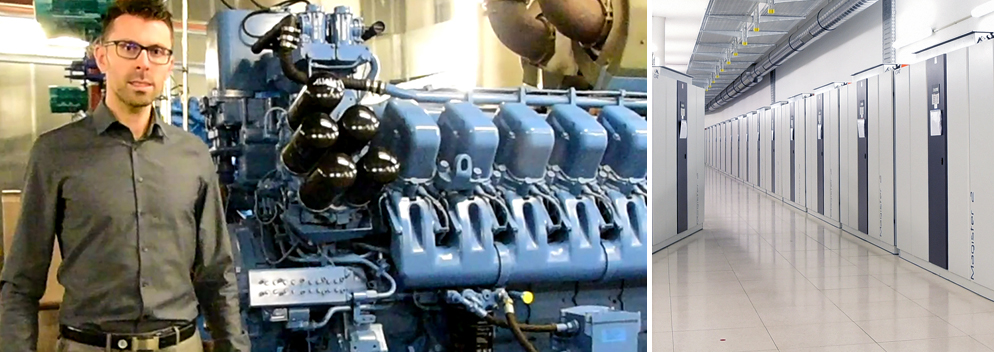

Jede der Datencenter-Hälften hat ihre eigene externe Stromversorgung. Wenn der Strom für beide komplett ausfällt, springen nach den Säure-Batterien die Notstrom-Diesel-Generatoren ein – die es natürlich ebenfalls zweimal gibt. Dabei handelt es sich um regelrechte Schiffsdiesel, wie Julien Roncalli erklärt: „Die haben etwa so viel Power wie 25 Autos!“

Julien Roncalli vor einem der Diesel-Generatoren, die das EDH im Notfall weiter betreiben können

Die Generatoren werden ständig vorgewärmt – um jederzeit innerhalb von nicht einmal 30 Sekunden starten zu können. Große Energiespeicher, in denen riesige Schwungräder rotieren, helfen dabei. Schließlich können so 2.500 Kilovoltampere Strom erzeugt werden – zunächst fünf Tage lang. Dafür stehen zwei Tanks mit je 50.000 Liter Diesel bereit. Ein solcher Ernstfall ist im energiesicheren Luxemburg zwar kaum anzunehmen – doch selbst, wenn das ganze Land tagelang im Dunkeln liegen sollte, kann man also andernorts weiter elektronisches Schiffeversenken spielen.

(Relativ) Cool bleiben!

In der Tiefe, in der der EDH liegt, ist es rund ums Jahr nur um die 12 Grad warm. Doch das reicht bei weitem nicht aus, um die Wärme auszugleichen, die die Server von sich geben, während sie emsig Aktienkurse berechnen, Newsletter verschicken oder torpedierte Kriegsschiffe in Pixelfluten versinken lassen.

Also wird über ein System von Wärmetauschern die warme Luft abgeleitet – und noch genutzt, um im Drosbach-Center die Büros zu heizen.

Natürlich könnte man Datenzentren auch einfach da errichten, wo die Außentemperaturen immer sehr niedrig sind: So betreibt Facebook etwa ein Zentrum in Schweden nahe des Polarkreises. Der CEO Mark Zuckerberg hat davon Bilder gepostet:

Und Microsoft experimentiert damit, ein Rechenzentrum komplett ferngesteuert in den kühlen Fluten der Nordsee zu betreiben. Dieses Datenzentrum für den Meeresgrund (Foto: Scott Eklund/Microsoft/dpa) ist ein Prototyp. Microsoft zufolge kann der etwa zwölf Meter lange Zylinder voller Computer bis zu fünf Jahre lang ohne Wartung Daten speichern und verarbeiten:

Allerdings stehen solchen Ideen wieder andere Anforderungen entgegen – beispielsweise die einer sehr schnellen und sicheren Datenanbindung oder die der Zugänglichkeit bei einer Störung.

Also müssen unter dem Drosbach-Center Wärmetauscher für kühlere Luft sorgen: Als riesige, graue Schränke ziehen sie sich einen endlosen Korridor entlang – ästhetisch erinnert das an das Raumschiff-Interieur aus Stanley Kubricks Sciene-Fiction-Klassiker „2001“.

Alle paar Meter verrät eine Anzeige, mit welchen Werten das jeweilige Gerät läuft. Selbstverständlich lassen sich diese Daten aber auch in einer Kommandozentrale ablesen: Daten von 15.000 Messpunkten werden dort zusammengeführt und aufbereitet.

Die Feuerwehr? Alles Flaschen!

Frieren muss man unter Tage übrigens nicht: Die Klimageräte kühlen die Luft nur auf ein Level, das auch für Menschen angenehm ist. Die Hardware wird zunehmend so entwickelt, dass sie problemlos bei immer höheren Temperaturen laufen kann. Das ist im Sinne des Umwelt – und der Energiekosten, denn Rechenzentren entwickeln sich zu immer problematischeren Ressourcenfressern (siehe Extra unten).

Sollte es aber punktuell doch mal entschieden zu warm werden und einer der Zehntausenden Umweltsensoren einen Brand registrieren, müssen etwa die empfindlichen Server trotzdem nicht sofort unter Wasser oder Schaum gesetzt werden: Denn jede Komplexhälfte verfügt auch über eine Löschgas-Anlage. Dazu stehen in einem weiteren Raum Dutzende Flaschen mit Argonit bereit: Über Ventile und Leitungen wird das erstickende Edelgas genau in den betroffenen Bereich geleitet.

Server: Unscheinbare Alleskönner

Wieder ein Sicherheitstüren weiter steht man schließlich in einem der Räume, in denen die Geräte laufen, um die der ganze Aufwand betrieben wird: Ziemlich unscheinbar stecken einige Server in ihren Racks, also genormten Gestellen, die wiederum in Schränken oder gleich ganzen Räumen weiter gruppiert werden.

(Symbolfoto)

(Symbolfoto)

Je nach Bedarf kann der Kunde alles mieten, vom einzelnen Rack-Einschub bis zum abgeschlossenen 1000-Quadratmeter-Raum. Seine Gerätschaften kann der Kunde dann völlig autark betreiben und warten. Gerade, wenn nur Kleinigkeiten zu machen sind – etwa ein Kabel umzustecken ist oder eine SD-Karte einzuschieben ist – sparen sich viele Kunden allerdings die Anreise und nutzen lieber den Technik-Service des Datenzentrums.

Einer der Server-Räume, in die das Tageblatt einen Einblick erhaschen konnte, bietet noch einigen Platz. Eine Werkbank, eine mannshohe Kabelrolle und andere Gerätschaften lassen jedoch erkennen, dass sich das bald ändern wird. „Wir bereiten hier gerade alles für einen neuen Kunden vor“, erklärt Hofmann, während neben ihm ein Schrank voller Server vor sich hin summt und blinkt. Ob die Geräte gerade vielleicht einen MRT-Scan für einen weit entfernten OP-Roboter aufbereiten, ein Millionenschweres Aktienpaket verschieben oder ein lustiges Katzenvideo auf ein Smartphone senden, ist ihnen von außen natürlich nicht anzusehen.

Doch was auch immer durch die Datenkabel (mehr als 20 Kilometer Glasfaser, mehr als 75 Kilometer Kupfer) fließt, die als bunte Stränge überall verlaufen – sie sind die Schlagadern, durch die im immer schnelleren Takt das digitale Blut gepumpt wird, ohne das unsere längst völlig Internet-abhängige Gesellschaft ziemlich schnell auf dem Rücken liegen würde.

Bis jetzt ist das System der doppelt- und dreifachen Sicherheit aber gut gegangen: Im YouTube-Clip der „World Of Warships“-Macher erklärt der technische Direktor Andre Reitenbach, wie lange das Datenzentrum in rund zehn Jahren Operationszeit offline war: 13 Sekunden.

Ressourcen-Fresser Datencenter

Wäre das Internet ein Land, dann hätte es Greenpeace zufolge heute schon den sechstgrößten Energieverbrauch aller Staaten weltweit. Und es wächst rasant – auch durch Cloud Computing und das „Internet der Dinge“: Experten schätzen, dass 2050 bis zu 50 Milliarden Geräte online sein werden. Vernetzte Autos sammeln schon heute mehr als 20 GB an Daten alle 100 Kilometer – von denen ein Großteil nicht beim Fahrzeug bleiben, sondern in die Welt verschickt werden soll.

Datenzentren spielen dabei eine entscheidende Rolle – allerdings verbrauchen sie schon heute 3 Prozent des weltweiten Stroms – und damit schon mehr als das gesamte Vereinigte Königreich zusammen. Außerdem stoßen sie global etwa 2 Prozent aller Treibhausgase aus. Pessimistische Prognosen gehen davon aus, dass Datenzentren schon in wenigen Jahren bis zu einem Fünftel des weltweiten Stroms verbrauchen könnten.

Zwar ist „Green IT“ ein wichtiges Thema und auch viele Datenzentren, wie auch das EDH, nutzen zum großen Teil Strom aus erneuerbaren Energien. Doch Kritiker weisen darauf hin, dass beispielsweise Amazon seit Jahren kaum Anstrengungen unternommen habe, um seine Datenzentren mit Ökostrom zu versorgen – und beste Kontakte zur Öl- und Kohleindustrie hält.

Der immense Stromhunger der Tech-Riesen beunruhigt jedenfalls auch die Kritiker des geplanten neuen Google-Datenzentrums in Luxemburg: So warnte eine Bürgerinitiative im Februar, das geplante Datenzentrum benötige eine 250-Megawatt-Anschlussleistung – und der prognostizierte Stromverbrauch von 2,5 Tetrawattstunden pro Jahr entspreche dem einer 200.000-Einwohner-Stadt. Das Netz werde hierfür nicht reichen, sodass neue Trassen für Hochspannungsleitungen gebaut werden müssten.

Dass Google sich Luxemburg vor allem wegen der günstigen Energiepreise ausgesucht habe, sei ein „No-Go“ in Zeiten des Klimawandels, findet das «Mouvement écologique» – und kritisiert auch den Landfraß, den das Vorhaben bedeute: So würden mehr als 30 Hektar der besten Böden in Bissen unwiederbringlich verloren gehen.

Well done, I appreciate the effort you put into this.