Drohnen, Minenräumkommandos, Verteidigungssysteme – der mögliche Einsatz künstlicher Intelligenz zu militärischen Zwecken ist quasi unbegrenzt. Das Luxemburger Verteidigungsministerium will den Einsatz von KI unterstützten oder gesteuerten autonomen Waffensystemen in der Luxemburger Armee regeln. „Die Digitalisierung ist Realität und die können wir nicht verhindern“, sagt Verteidigungsminister François Bausch auf einer Pressekonferenz am Montag in der Verteidigungsdirektion. Es wäre demnach wenig

sinnvoll, den Einsatz zu verbieten. „Es braucht stattdessen Regeln, weil solche Waffen eine extreme

Bedrohung darstellen.“ Mehr noch als Nuklearsprengköpfe, meint Bausch, denn: „KI-Waffensysteme sind weniger kompliziert und ressourcenintensiv und die Verbreitung solcher Waffen ist relativ einfach.“ Autonome Waffensysteme aber würden auch Vorteile mit sich bringen, die das Leben von Soldaten schützen könnten. So etwa, wenn sie zur Räumung von Minenfeldern oder Sprengfallen eingesetzt werden würden. „Die Gefahr liegt viel eher im unkontrollierten Einsatz ohne klare Linien.“ KI-basierte Technologie zu verbieten, bringe sowieso nichts, weil es ja nicht nur militärische Applikationen gebe – und man dementsprechend der Technologie nur hinterherlaufen würde. Seit Juli 2022 hätte sich eine interministerielle Arbeitsgruppe damit beschäftigt, die Luxemburger Position zu autonomen Waffensystemen zu erarbeiten.

„Es gibt keine international anerkannte Definition, sodass wir erst einmal eine nationale Definition

ausarbeiten mussten“, sagt Ben Fetler aus der Verteidigungsdirektion. Unter autonomen Waffensystemen

versteht das Luxemburger Verteidigungsministerium demnach fortan alle Waffensysteme, die „autonom

identifizieren, auswählen und angreifen können“, erklärt Fetler. Dass in der Definition „tödlich“ nicht

vorkommt, sei gewollt. „Andere Länder sehen Verteidigungssysteme als nicht tödliche Waffensysteme an –

und würden sich demnach der Definition und den Regulierungen entziehen können.“ Es müsse demnach

eher die Funktionalität der Waffe und weniger die Einsatzabsichten bei einer Definition berücksichtigt

werden.

Des systèmes d’armes capables d’identifier, de sélectionner et de déployer une force contre une cible sans intervention humaine

Aufgrund dieser Definition wird sich Luxemburg laut Ben Fetler auf internationaler Ebene darum bemühen, die Verwendung komplett autonomer Waffensysteme ohne menschliche Kontrolle zu verbieten. „Diese Waffensysteme stehen ohnehin nicht im Einklang mit internationalen Konventionen“, sagt Fetler. Alle weiteren Waffensysteme sollen demnach internationalen Regeln unterworfen werden. „Wichtig sind zwei Prinzipien: Der Mensch muss die Kontrolle haben und trägt die Verantwortung für den Einsatz dieser Waffen.“

Prinzipien, die jedoch Fragen aufwerfen: Wann kontrolliert ein Mensch ein KI-basiertes Waffensystem? Und welches Verständnis der Technologie muss ein Soldat haben, um beim Einsatz solcher Waffen als verantwortlich gelten zu können? Der international anerkannte Experte Paul Scharre verglich im Tageblatt-Interview die Anwendung von Waffensystemen mit dem Bedienen einer Mikrowelle oder eines Autos – deren Technik ein Großteil der Benutzer ebenfalls nicht verstehen würde. „Wir brauchen also ein Verständnis von den Möglichkeiten und Fähigkeiten, die eine Maschine besitzt – egal ob im persönlichen oder militärischen Kontext. Eine bestimmte Berufsgruppe, das Militär, setzt diese Technologien ein. Sie kennen die Grenzen der Technologie und unter welchen Umständen diese eingesetzt werden kann“, erklärt Scharre während der Autonomous Lethal Weapons Conference auf Belval im April 2023.

Autonomie

Paul Scharre unterscheidet in seinem Buch „Army of None“ zwischen mehreren Dimensionen von Autonomie, die von Komplexität, Verhältnis zwischen Mensch und Maschine sowie der Intelligenz des Systems abhängig sind. Das Verhältnis zwischen Maschine und Mensch unterteilt Scharre in drei Subkategorien: halbautonome Systeme, überwachte autonome Systeme und komplett autonome Systeme. Halbautonome Systeme erfassen Informationen unabhängig vom Menschen, sind jedoch von dessen Input abhängig, um ihrer Aufgabe nachgehen zu können. Der Mensch ist demnach direkt in den Entscheidungsablauf eingebunden. Überwachte autonome Systeme hingegen funktionieren ohne Input einer Person – diese kann jedoch zu jederzeit eingreifen, falls nötig. Komplett autonome Systeme funktionieren ebenfalls unabhängig – und Menschen können bei der Ausführung der Aufgabe auch nicht mehr entscheidend eingreifen. Die israelische IAI Harop, ein unbemanntes Luftfahrzeug der israelischen Armee, ist ein Beispiel eines komplett autonomen Waffensystems. Sie ist darauf ausgelegt, gegnerische Radarsysteme zu erkennen und auszuschalten.

Luxemburg will jedoch einen Schritt weitergehen. „Von der Bildaufnahme bis hin zum Schießbefehl muss der Mensch für alles die Verantwortung tragen“, erklärt Fetler – und demnach auch die entsprechenden Kenntnisse mitbringen. „Deshalb ist das neue Kadergesetz in der Armee so wichtig, weil es Einstellungen in Karrieregraden ermöglicht, die einem Bachelorabschluss entsprechen“, sagt Verteidigungsminister Bausch. Wie viel Kontrolle von einem Menschen ausgeübt werden soll, müsse jedoch vom spezifischen System abhängig gemacht werden, sagt Fetler. „Bei einer Minenentschärfung ist weniger Kontrolle nötig als bei einer tödlichen Waffe“, so Fetler. Nur soviel stehe fest: Komplett autonome Systeme (siehe Infobox), bei der der Mensch nicht mehr entscheidend eingreifen kann, kommen für Luxemburg nicht infrage.

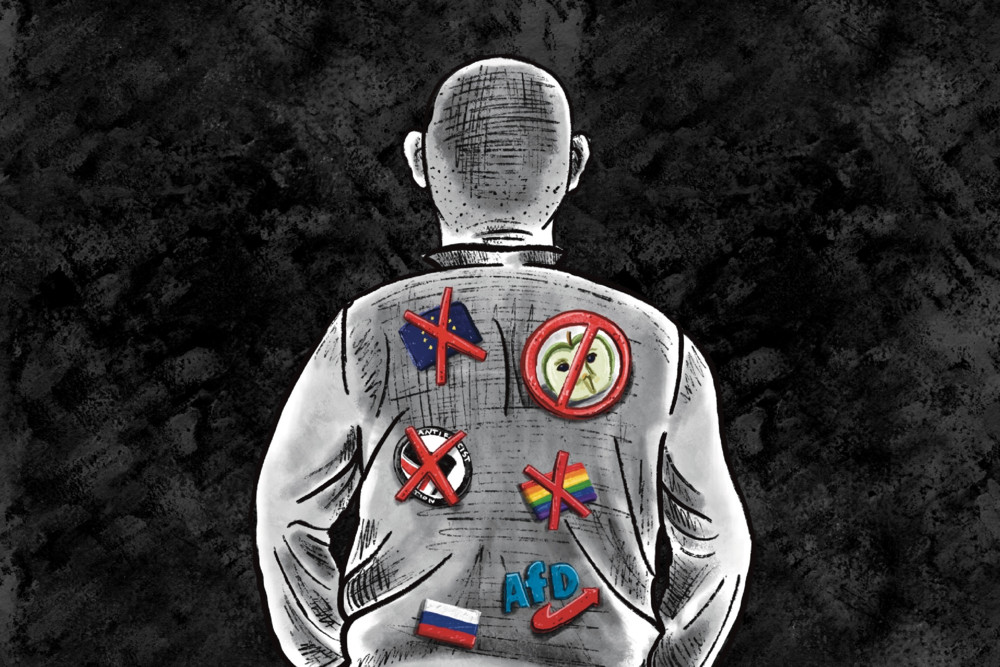

Mit dieser Position vertritt Luxemburg „die gesunde Mitte“ auf internationaler Ebene. Gänzlich gegen die Entwicklung und den Einsatz solcher Systeme sei beispielsweise Costa Rica – während sich gerade die großen Militärmächte anfangs sehr zurückhaltend bei der Regulierung solcher Waffensysteme gezeigt haben. „Sie wollen ihren strategischen Vorteil bei der Entwicklung solcher Waffensysteme nicht gefährdet sehen“, sagt Bausch. Jedoch habe in den vergangenen Jahren und Monaten ein Umdenken stattgefunden – „das Risiko, dass solche Waffensysteme in die falschen Hände gelangen, ist beträchtlich“, erklärt Verteidigungsminister Bausch. Zudem sei die Entwicklung der KI nicht ausschließlich militärisch orientiert – die daraus resultierenden technologischen Errungenschaften können späterhin dennoch auf dem Schlachtfeld zum Einsatz kommen. Ein Punkt, der gerade Wissenschaftler dazu veranlasse, Druck auf die internationale Gemeinschaft auszuüben, um den Einsatz autonomer Waffensysteme zu regulieren, so Bausch.

Luxemburgs Aktionsplan für autonome Waffensysteme

Die interministerielle Arbeitsgruppe hat neben einer Definition für autonome Waffensysteme acht Vorschläge ausgearbeitet, wie zukünftig mit dem Thema autonome Waffensysteme verfahren werden soll: Luxemburgs zweigleisiger Ansatz – Verbot komplett autonomer Waffen und Regulierung KI-basierter Waffensysteme – soll auf internationalem Parkett gefördert und in internationalen Arbeitsgruppen innerhalb der Vereinten Nationen, der NATO und EU vertreten werden. Außerdem ist vorgesehen, die Entwicklung von zivilen KI-Technologien auf deren Einsatzmöglichkeiten im militärischen Bereich zu überprüfen und die Rechercheinstitute in der Hinsicht zu sensibilisieren. Leitende Recherchezentren sollen identifiziert, Rechercheprojekte angestoßen und bereits existierende autonome Waffensysteme auf deren Kompatibilität mit internationalen Standards überprüft werden. Auch sollen die ethischen Implikationen beim Einsatz autonomer Waffensysteme erläutert werden, ggf. in die Charta der Luxemburger Armee aufgenommen werden. Zudem schlägt die Arbeitsgruppe vor, einen Ethikausschuss auf staatlicher Ebene einzusetzen, der sich aus KI-Experten zusammensetzt.

Zu Demaart

Zu Demaart

Sie müssen angemeldet sein um kommentieren zu können